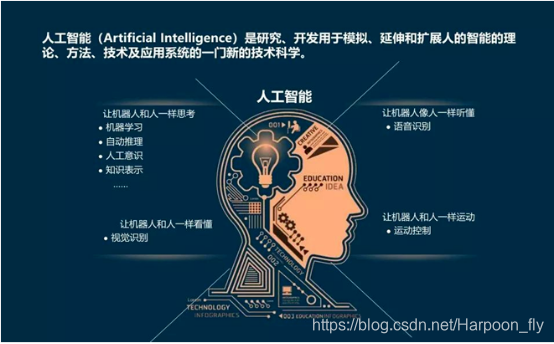

人工智能(AI)能听懂人类语言并做出相应动作,本质是通过一套 **“信号转换→语言理解→逻辑决策→动作执行”** 的完整技术链条实现的。其中,人类语言在 AI 内部会经历多次 “形态转换”,从 AI 无法直接理解的 “自然语言”,变成可计算、可分析的 “数字信号”,最终转化为驱动动作的 “指令代码”。

下面我们分步骤拆解这个过程,重点解析语言在 AI 内部的 “变形之旅” ,以及 AI 如何从 “听懂” 到 “行动”。

一、第一步:把 “人类语言” 变成 AI 能 “看见” 的信号(输入层转换)

人类语言的载体有两种:语音(说话) 和文字(打字 / 手写) 。AI 首先要把这两种 “非数字信号” 转化为自己能处理的 “数字符号”,这是 “听懂” 的基础。

1. 若输入是 “语音”(比如你对智能音箱说 “打开灯光”)

转化目标:将连续的 “声波信号”→ 离散的 “文字符号”(即语音识别)。

技术过程:

声波采样:AI 通过麦克风接收你的语音(本质是空气振动形成的声波),将声波转化为连续的电信号,再通过 “采样” 把连续信号切成一个个离散的 “数字片段”(类似把电影拆成一帧帧画面)。

特征提取:从数字片段中提取 “语音特征”(如音调、频率、音色),这些特征能区分不同的发音(比如 “打” 和 “开” 的发音差异)。

语音转文字(ASR):通过 “自动语音识别模型(ASR)”,将语音特征与预设的 “发音词典” 匹配,比如把 “dǎ kāi dēng guāng” 的发音特征,对应到文字 “打开灯光”。

语言形态变化:声波(物理信号) → 数字片段 → 语音特征向量 → 文字符号。

2. 若输入是 “文字”(比如你在手机上输入 “关闭空调”)

转化目标:将人类可读的 “文字符号”→ AI 可计算的 “数字编码”。

技术过程:

分词 / 预处理:

对于中文:先 “分词”(比如 “关闭空调” 拆成 “关闭”“空调” 两个词,因为中文句子没有天然的 “词边界”)。

对于英文:直接按空格拆分单词(如 “Turn off the air conditioner” 拆成单个单词)。

符号编码:给每个词分配一个唯一的 “数字 ID”(比如 “关闭”=102,“空调”=205),把文字序列转化为数字序列(如 “关闭空调”→ [102, 205])。

语言形态变化:文字符号(人类可读) → 分词后的词序列 → 数字 ID 序列(AI 可读)。

二、第二步:让 AI “理解” 语言的真实含义(核心理解层)

这是最关键的一步。AI 拿到 “数字 ID 序列” 后,还需要理解这些文字背后的语义(意思) 、意图(你想做什么) 和实体(涉及的对象) ,比如 “打开灯光” 的意图是 “控制设备”,实体是 “灯光”,动作是 “打开”。

这一步的核心是让语言从 “离散的数字 ID”,变成能表达 “语义关系” 的 “向量”(一种数学坐标,类似用 x/y 轴描述一个点的位置,AI 通过向量的 “距离” 判断语义的相似度)。

1. 词向量:给每个词 “赋予语义”

技术原理:通过 “词嵌入模型(如 Word2Vec、BERT)”,将每个词的数字 ID 转化为 “词向量(Embedding)”。

例如:“国王” 的词向量 ≈ “女王” 的词向量 + “男性” 的词向量 - “女性” 的词向量,这说明 AI 通过向量能捕捉到 “国王” 和 “女王” 的语义关联(身份相似,性别相反)。

对于 “打开灯光”,“打开” 的词向量会包含 “动作、启动” 的语义,“灯光” 的词向量会包含 “设备、照明” 的语义。

语言形态变化:数字 ID 序列 → 词向量序列(带语义的数学向量)。

2. 上下文理解:搞懂 “一句话的完整意思”

单个词的语义不够,AI 还需要结合 “上下文” 理解整句话的逻辑。比如 “苹果” 可能指水果,也可能指手机,必须通过上下文判断(如 “吃苹果”→ 水果,“买苹果”→ 手机,需结合场景)。

技术核心:依赖大模型的 “注意力机制(Attention)”(如 Transformer 架构)。

原理:AI 会给句子中不同的词分配 “注意力权重”,重点关注与 “核心意图” 相关的词。比如 “打开客厅的灯光”,AI 会给 “打开”(动作)、“灯光”(对象)、“客厅”(位置)分配更高的权重,忽略无关的辅助词(如 “的”)。

输出:通过注意力机制,将所有词的向量融合成一个 “句子级向量”,这个向量完整包含了整句话的 “意图、对象、场景” 等信息(比如 “动作:打开;对象:灯光;位置:客厅”)。

语言形态变化:词向量序列 → 句子级语义向量(包含完整意图的数学向量)。

3. 意图与实体识别:明确 “你想让 AI 做什么”

AI 需要从 “句子级语义向量” 中,提取两个关键信息:

意图(Intent):你要完成的核心任务,比如 “控制家电”“查询天气”“导航到公司”。

实体(Entity):任务涉及的具体对象,比如 “家电 = 灯光”“位置 = 客厅”“时间 = 明天”。

举例:

输入 “把卧室空调调到 26 度”:

意图:控制家电(空调调节温度)。

实体:设备 = 空调,位置 = 卧室,温度 = 26 度。

语言形态变化:句子级语义向量 → 结构化意图 + 实体(如:{意图:控制空调,参数:{位置:卧室,温度:26}})。

三、第三步:根据 “理解” 生成 “动作指令”(决策与输出层)

AI 理解你的意图后,需要将 “结构化的意图 + 实体” 转化为 “可执行的动作指令”—— 如果是软件操作(如手机助手查天气),指令是 “数据查询代码”;如果是硬件操作(如机器人、智能家电),指令是 “硬件控制信号”。

1. 针对 “软件类动作”(如查天气、发消息)

过程:AI 将 “意图 + 实体” 映射为 “API 接口调用指令”(API 是不同软件之间的 “通信协议”)。

举例:输入 “查北京明天的天气”,AI 生成指令:调用天气API,参数:城市=北京,日期=明天,返回结果=温度、降水概率。

后续:API 返回数据后,AI 再将数据转化为自然语言(如 “北京明天晴,气温 20-28 度”),完成 “响应”。

2. 针对 “硬件类动作”(如机器人抓取物体、智能灯开关)

过程:AI 将 “意图 + 实体” 映射为 “硬件控制指令”(即驱动电机、传感器的代码)。

举例 1:对智能灯说 “打开客厅灯光”,AI 生成指令:向客厅灯光的智能模块发送信号,指令码=01(代表打开),亮度=100%。

举例 2:对机器人说 “把桌上的杯子拿给我”,AI 生成指令:

先通过视觉模型识别 “杯子” 在桌面上的坐标(如 x=50cm,y=30cm);

生成机械臂运动指令:机械臂移动到(50,30)位置,爪子张开角度=60度,抓取力度=20N,提升高度=10cm,移动到用户面前(x=100cm,y=80cm),爪子张开。

语言形态变化:结构化意图 + 实体 → 软件 API 指令 / 硬件控制代码(机器可执行的二进制信号)。

四、第四步:执行动作并反馈(闭环验证)

AI 生成的 “动作指令” 通过硬件接口(如蓝牙、Wi-Fi、数据线)传递给执行机构,最终完成动作:

智能家电:接收指令后,继电器、电机等部件启动(如灯光通电、空调压缩机运转)。

机器人:机械臂、轮子等根据控制代码运动,完成抓取、移动等动作。

同时,部分 AI 会通过传感器(如摄像头、温度传感器)“验证动作结果”,形成闭环:比如机器人抓取杯子后,通过视觉确认 “是否抓稳”,若没抓稳则重新调整指令。

总结:语言在 AI 内部的 “完整变形路径”

以 “对智能机器人说‘打开客厅灯光’” 为例,语言的形态变化全程如下:

声波信号(你说话的声音)→

数字片段 + 语音特征(麦克风采样与特征提取)→

文字符号 “打开客厅灯光”(ASR 语音转文字)→

数字 ID 序列 [102, 301, 205](分词与编码)→

词向量序列(每个词的语义向量)→

句子级语义向量(包含 “动作:打开,对象:灯光,位置:客厅”)→

结构化意图 + 实体({意图:控制灯光,参数:位置 = 客厅,状态 = 打开})→

硬件控制代码(向客厅灯光模块发送 “打开” 信号,向机器人发送 “移动到灯光开关处” 的机械臂指令)→

物理动作(灯光亮起,机器人完成操作)。

关键技术支撑:为什么 AI 能 “理解” 而非 “机械匹配”?

过去的 “伪智能”(如早期手机语音助手)只能通过 “关键词匹配”(比如听到 “打开灯光” 就执行预设指令),无法处理复杂语言(如 “把客厅灯光调暗一半”)。而现在的 AI 能真正 “理解”,核心依赖两大技术:

大语言模型(LLM):通过海量文本训练,掌握了人类语言的语义、逻辑和常识,能处理歧义、复杂指令(如 “先开空调再关灯” 的先后顺序)。

多模态融合:若涉及动作执行(如机器人),AI 会融合 “语言理解” 与 “计算机视觉”(识别物体位置)、“运动控制”(规划机械臂路径)等多模块能力,实现 “听懂” 到 “行动” 的闭环。

简单来说,AI “听懂语言并动作” 的本质,是将人类的 “自然语言” 层层转化为 “机器可计算的数学信号”,再通过逻辑决策生成 “可执行的物理指令”—— 整个过程就像人类 “听到指令→理解意思→思考怎么做→动手执行” 的数字化复刻。